La Unión Europea ha decidido asumir un rol protagónico en el debate sobre cómo deben regularse las tecnologías de Inteligencia Artificial (IA). En octubre de 2025, el Reglamento Europeo de Inteligencia Artificial (RIA o AI Act) ya no es un simple proyecto, sino un cuerpo normativo que comienza a desplegar efectos reales. El objetivo declarado es ambicioso: garantizar que la IA se desarrolle y utilice dentro de un marco que respete los derechos fundamentales de las personas. Sin embargo, este esfuerzo también plantea dilemas complejos que van desde la carga regulatoria hasta la interpretación judicial de conceptos aún difusos.

Este avance normativo europeo representa mucho más que un listado de prohibiciones y obligaciones. Es un intento de establecer un pacto social y jurídico alrededor de una tecnología que tiene el potencial de redefinir la vida económica, política y cultural. Y como ocurre en toda iniciativa de gran escala, el impacto no se limita a las fronteras europeas: la sombra de Bruselas alcanza a empresas, gobiernos y tribunales en todo el mundo.

El análisis del RIA nos obliga, entonces, a movernos en dos planos: el técnico, donde se definen riesgos y obligaciones concretas; y el estratégico, donde se juega la competitividad de empresas, el equilibrio regulatorio y el alcance de los derechos de las personas en la era digital.

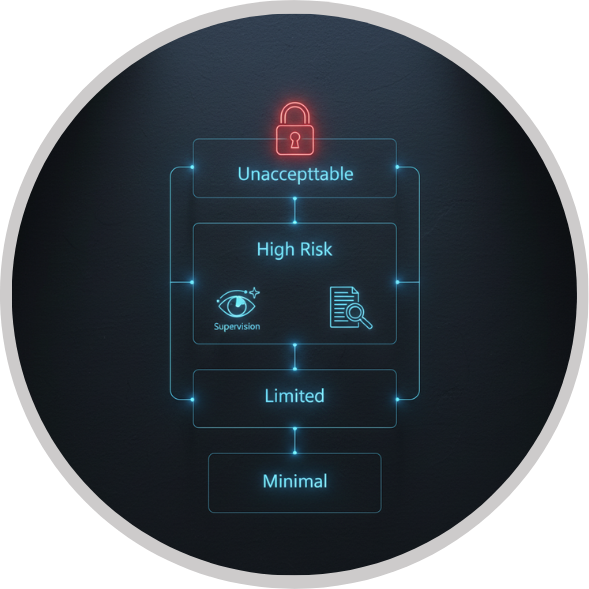

El RIA estructura la regulación de la IA en función del nivel de riesgo. De este modo, se identifican cuatro categorías: riesgo inaceptable, alto riesgo, riesgo limitado y riesgo mínimo. La idea es sencilla en apariencia: cuanto mayor sea la probabilidad de daño, mayores deben ser los controles. En la práctica, sin embargo, esta clasificación supone un reto para empresas y autoridades que deberán determinar en qué nivel se encuentra cada sistema y cómo cumplir con las obligaciones correspondientes.

Las prácticas consideradas de riesgo inaceptable son especialmente relevantes. Aquí se ubican aquellas aplicaciones que se consideran contrarias a la dignidad y los derechos fundamentales: manipulación subliminal, explotación de vulnerabilidades por edad o discapacidad, sistemas de puntuación social, predicción de delitos a partir de perfiles, creación masiva de bases de datos faciales sin consentimiento, inferencia emocional en espacios laborales o educativos, y el reconocimiento biométrico en tiempo real en lugares públicos. Estos usos están expresamente prohibidos, y su incumplimiento acarrea sanciones económicas que pueden superar los 30 millones de euros o el 7 % de la facturación anual de la empresa.

Por encima de estas prohibiciones, el Reglamento también impone un régimen de obligaciones estrictas para los sistemas de alto riesgo. Estos abarcan desde la gestión de riesgos y la calidad de los datos de entrenamiento hasta la documentación técnica, la trazabilidad y la supervisión humana. El propósito es garantizar que las decisiones de la IA no queden en la opacidad, sino que exista un rastro verificable que permita comprender cómo y por qué un sistema toma determinada decisión. Incluso los modelos de propósito general — capaces de ser utilizados en múltiples aplicaciones — están sujetos a reglas específicas, como reportar incidentes, documentar los conjuntos de entrenamiento y establecer protocolos de seguridad.

Uno de los mayores desafíos del RIA es cómo equilibrar la innovación con la protección de derechos fundamentales. Si bien la intención de la Unión Europea es clara, existe el riesgo de que el exceso de carga regulatoria afecte la competitividad de las startups y pequeñas empresas tecnológicas. Estas carecen, en muchos casos, de los recursos necesarios para implementar auditorías, documentar procesos y sostener el nivel de cumplimiento exigido. Por contraste, los grandes actores tecnológicos cuentan con departamentos legales y técnicos que les permiten absorber con mayor facilidad estas exigencias.

Además, el Reglamento plantea problemas de interpretación conceptual. ¿Qué se entiende exactamente por manipulación subliminal? ¿Hasta dónde una estrategia de personalización de contenido deja de ser legítima y pasa a convertirse en explotación de vulnerabilidades? Estas preguntas no son triviales. El modo en que los tribunales y autoridades interpreten estas disposiciones determinará el alcance real del RIA y la seguridad jurídica de las empresas. La ambigüedad puede derivar en disputas judiciales complejas y en la necesidad de que el Tribunal de Justicia de la Unión Europea siente precedentes.

El carácter extraterritorial del RIA también genera interrogantes. Aunque es una norma europea, su aplicación se extiende a proveedores que, aun estando fuera del continente, ofrezcan servicios que impacten en el mercado europeo. Esto obliga a compañías de América Latina, Asia y otras regiones a revisar sus modelos de negocio si pretenden operar con clientes europeos. Sin embargo, ejecutar esta extraterritorialidad no será sencillo: ¿cómo imponer sanciones a empresas sin presencia física en Europa? Esta tensión refleja la ambición de la norma, pero también anticipa conflictos de jurisdicción y de cumplimiento.

Más allá de Europa, el RIA se proyecta como un referente regulatorio internacional. América Latina, por ejemplo, podría ver en este marco un modelo a seguir —aunque con adaptaciones necesarias a sus propias realidades sociales y económicas—. En países donde el debate sobre la regulación de la IA apenas comienza, la experiencia europea puede servir de inspiración, pero también de advertencia sobre las tensiones que acarrea intentar legislar una tecnología en constante evolución.

Para las empresas latinoamericanas, especialmente aquellas que buscan expandirse hacia el mercado europeo, el RIA no es un tema ajeno. Sus obligaciones se convierten en un estándar que deberán cumplir si quieren operar en ese entorno. Esto abre oportunidades para que firmas locales se posicionen como expertas en “IA conforme a Europa”, pero también impone costos que podrían dejar fuera de juego a actores emergentes. El impacto, por tanto, no será solo legal, sino también económico y estratégico.

Por otro lado, el Acta Europea también plantea un mensaje político: Europa quiere liderar la conversación global sobre la ética y el control de la IA. Al igual que ocurrió con el Reglamento General de Protección de Datos (RGPD), el llamado “efecto Bruselas” puede marcar la pauta para otros países y organismos internacionales. Sin embargo, esta ambición también enfrenta riesgos: mientras Europa regula con firmeza, Estados Unidos y Asia podrían avanzar en el desarrollo de IA sin las mismas restricciones, generando un desbalance competitivo.

El Acta Europea de Inteligencia Artificial representa una apuesta audaz: construir un marco legal que ponga límites claros al poder de la tecnología sin frenar su potencial transformador. Sus prohibiciones buscan proteger a los ciudadanos de prácticas dañinas, y sus obligaciones intentan garantizar transparencia y responsabilidad en el uso de la IA. Pero al mismo tiempo, la norma abre interrogantes sobre su impacto en la innovación, su viabilidad extraterritorial y la protección real de las víctimas frente a abusos algorítmicos.

Para América Latina, este nuevo marco es tanto una referencia como una advertencia. No basta con copiar el modelo europeo: será necesario adaptarlo a contextos distintos, donde los desafíos de inclusión digital, competitividad y capacidad institucional marcan realidades muy diversas. El reto será aprender de las tensiones europeas y proyectar soluciones propias que equilibren innovación, derechos y desarrollo económico.

En definitiva, el RIA no es un simple reglamento: es el inicio de un pacto regulatorio global en torno a la inteligencia artificial. Y aunque aún queda mucho camino por recorrer, su impacto ya se hace sentir en debates legislativos, en estrategias empresariales y en el modo en que entendemos la relación entre tecnología y derechos en el siglo XXI.